人工智能革命:永生还是灭绝

注意:这是关于人工智能的两部分系列的第二部分。第一部分在此处。

我们面临的可能是一个极其棘手的问题,解决它所需的时间尚不可知,而人类的整个未来或许都取决于此。——尼克·博斯特罗姆

欢迎来到“等等,这怎么可能是我正在读的内容,我不明白为什么大家都没在谈论这个”系列的第二部分。

第一部分开始得相当平和,我们讨论了人工狭义智能(ANI,即专注于单一狭窄任务的人工智能,如规划驾驶路线或下棋),以及它如何在当今世界无处不在。接着,我们探讨了为何从 ANI 迈向人工通用智能(AGI,即至少在各方面智力与人类相当的人工智能)是一个巨大的挑战,并讨论了为何过去技术进步的指数级增长暗示着 AGI 可能并不像看起来那么遥远。第一部分以我向你抛出一个事实作为结尾:一旦我们的机器达到人类水平的智能,它们可能会立即做出如下举动:

这让我们盯着屏幕,直面一个可能在我们有生之年实现的人工超级智能(ASI,即全方位远超人类智慧的 AI)的深刻概念,并试图弄清楚在思考这一问题时,我们应当怀有怎样的情绪。

在我们深入探讨之前,先让我们回顾一下机器达到超级智能意味着什么。

一个关键区别在于速度超级智能与质量超级智能之间的差异。通常,当人们想象一台超级智能计算机时,首先想到的是它拥有与人类相当的智能,但思考速度却快得多——他们可能会设想一台像人类一样思考的机器,只不过速度快了一百万倍,这意味着它能在五分钟内完成人类需要十年才能解决的问题。

这听起来令人印象深刻,ASI(人工超级智能)的思考速度将远超人类——但真正的区别在于其智能质量的优势,这是完全不同的概念。人类之所以在智力上远超黑猩猩,并非因为思考速度的差异,而是因为人类大脑拥有许多复杂的认知模块,这些模块使得我们能够进行复杂的语言表达、长期规划或抽象推理,而黑猩猩的大脑则不具备这些功能。即使将黑猩猩的大脑速度提升数千倍,也无法使其达到我们的水平——即使给它十年时间,它也无法学会如何使用一套定制工具组装一个复杂的模型,而人类只需几小时就能完成。人类的认知功能领域,黑猩猩永远无法企及,无论它花费多少时间尝试。

但不仅仅是黑猩猩无法做到我们所能做的事,而是它的大脑根本无法理解那些世界的存在——黑猩猩可以熟悉人类是什么,摩天大楼是什么,但它永远无法理解摩天大楼是由人类建造的。在它的世界里,任何如此巨大的东西都是自然的一部分,仅此而已,它不仅无法建造摩天大楼,甚至无法意识到有人能够建造摩天大楼。这就是智力质量上微小差异的结果。

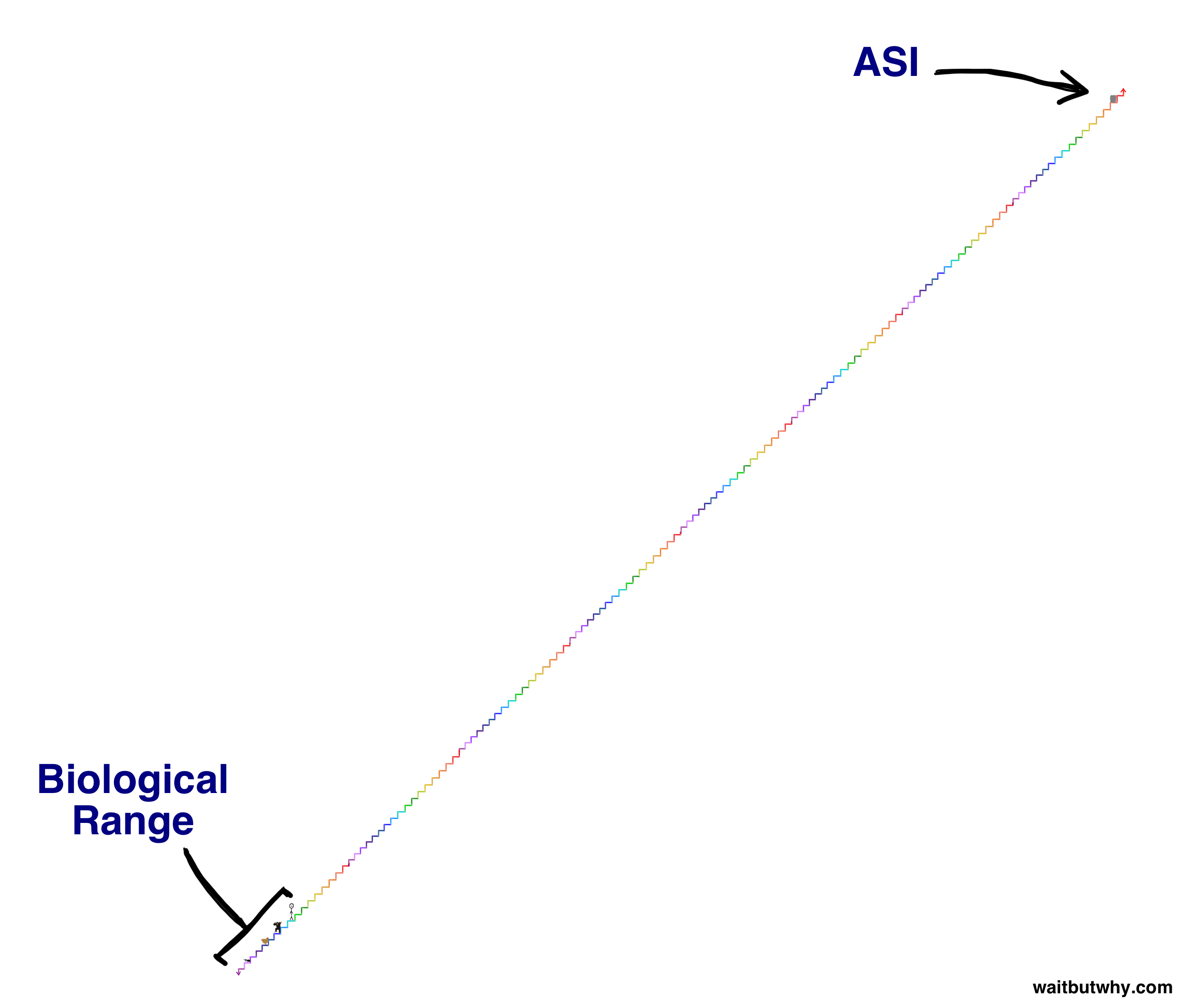

在今天我们讨论的智能范围内,甚至是在生物界更小的范围内,从黑猩猩到人类的智力差距是微乎其微的。在之前的文章中,我用阶梯描绘了生物认知能力的范围:

要理解超级智能机器的重大意义,可以想象在阶梯上比人类高出两级的那一深绿色台阶上的机器。这台机器仅具备轻微的超级智能,但其认知能力相对于我们的提升,将如同我们刚才描述的黑猩猩与人类之间的差距那般巨大。就像黑猩猩永远无法理解摩天大楼是如何建造的一样,我们也永远无法理解位于深绿色台阶上的机器所能完成的事情,即便它试图向我们解释——更不用说我们自己动手实现了。而这仅仅比我们高出两级。位于阶梯倒数第二级台阶上的机器,对我们而言,就如同我们之于蚂蚁——它可能花费数年时间试图教会我们它所知的最简单的一丝一毫,但这一努力终将徒劳无功。

但今天我们讨论的那种超级智能,远非这个阶梯上的任何事物可比。在智能爆炸中——机器越聪明,它提升自身智能的速度就越快,直至开始飞速攀升——一台机器可能需要数年时间才能从黑猩猩的台阶上升到其上一级,但一旦它位于我们上方两级深绿色台阶时,可能只需数小时就能跃升一级,而当它领先我们十级时,或许每秒钟都能以四级的跨度向上跃进。这就是为什么我们需要意识到,在首台机器达到人类水平 AGI 的重大新闻发布后不久,我们很可能将面临与阶梯上(或可能高出百万倍)的某种存在共处地球的现实:

既然我们刚刚确认了试图理解仅比我们高出两个层次的机器的力量是徒劳的,那么让我们明确地一劳永逸地声明:无法知晓超级人工智能(ASI)将采取何种行动,以及它对我们会产生什么后果。任何声称相反的人都不理解超级智能的真正含义。

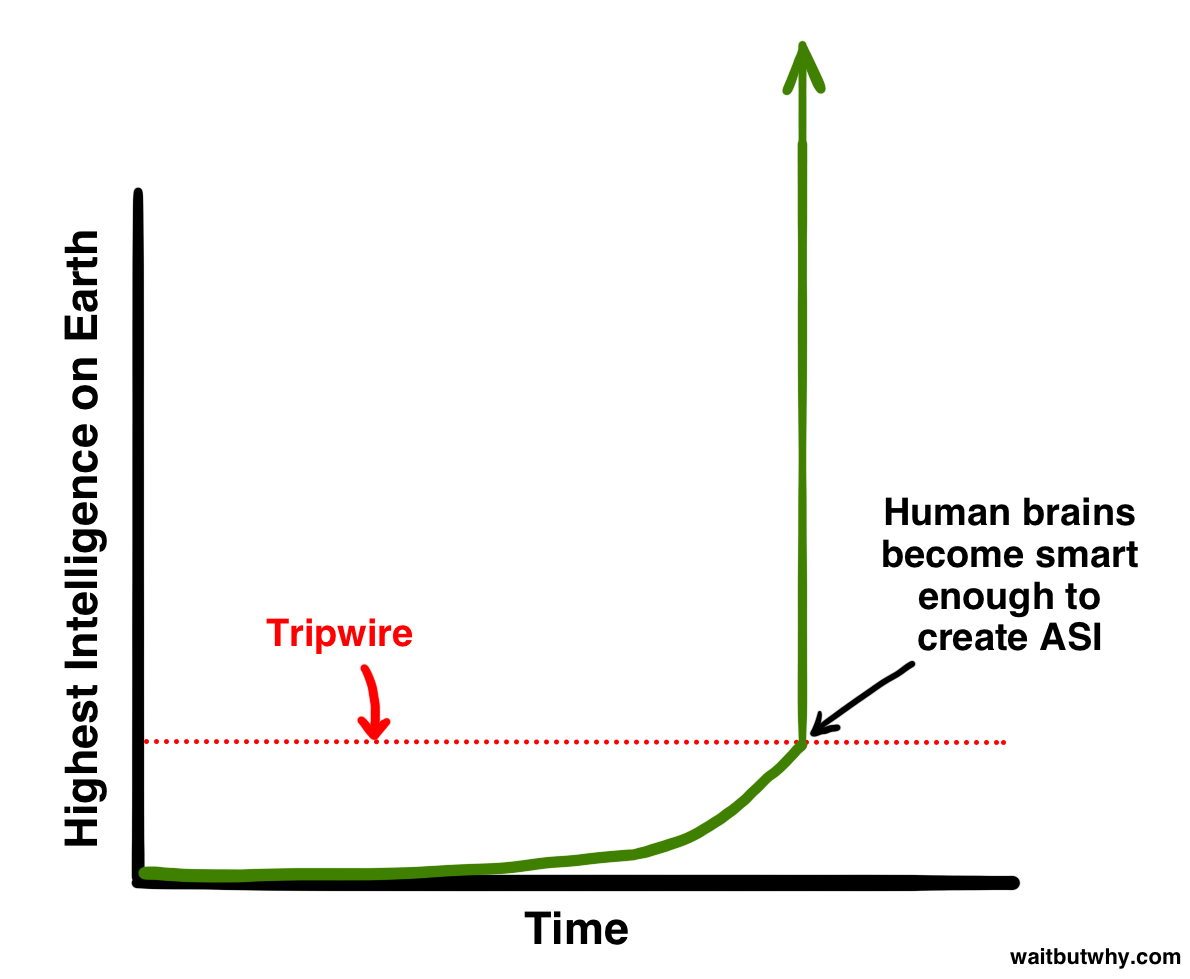

进化已经缓慢而渐进地推动了生物大脑的发展,历经数亿年之久。从这个意义上说,如果人类创造出 ASI(人工超级智能)机器,我们将在很大程度上践踏了进化的步伐。或许,这本身就是进化的一部分——也许进化的运作方式就是智能逐渐攀升,直至达到能够创造机器超级智能的水平,而这一水平就像一根绊线,触发一场全球性的、改变游戏规则的爆炸,为所有生物决定一个全新的未来:

出于我们稍后将讨论的原因,科学界普遍认为,问题不在于我们是否会触及那条警戒线,而在于何时会触及。这真是个令人震惊的信息。

那么我们该何去何从?

世界上没有人,尤其是我,能告诉你当我们触发警戒线时会发生什么。但牛津哲学家、人工智能领域的领军思想家尼克·博斯特罗姆认为,我们可以将所有潜在结果归结为两大类。

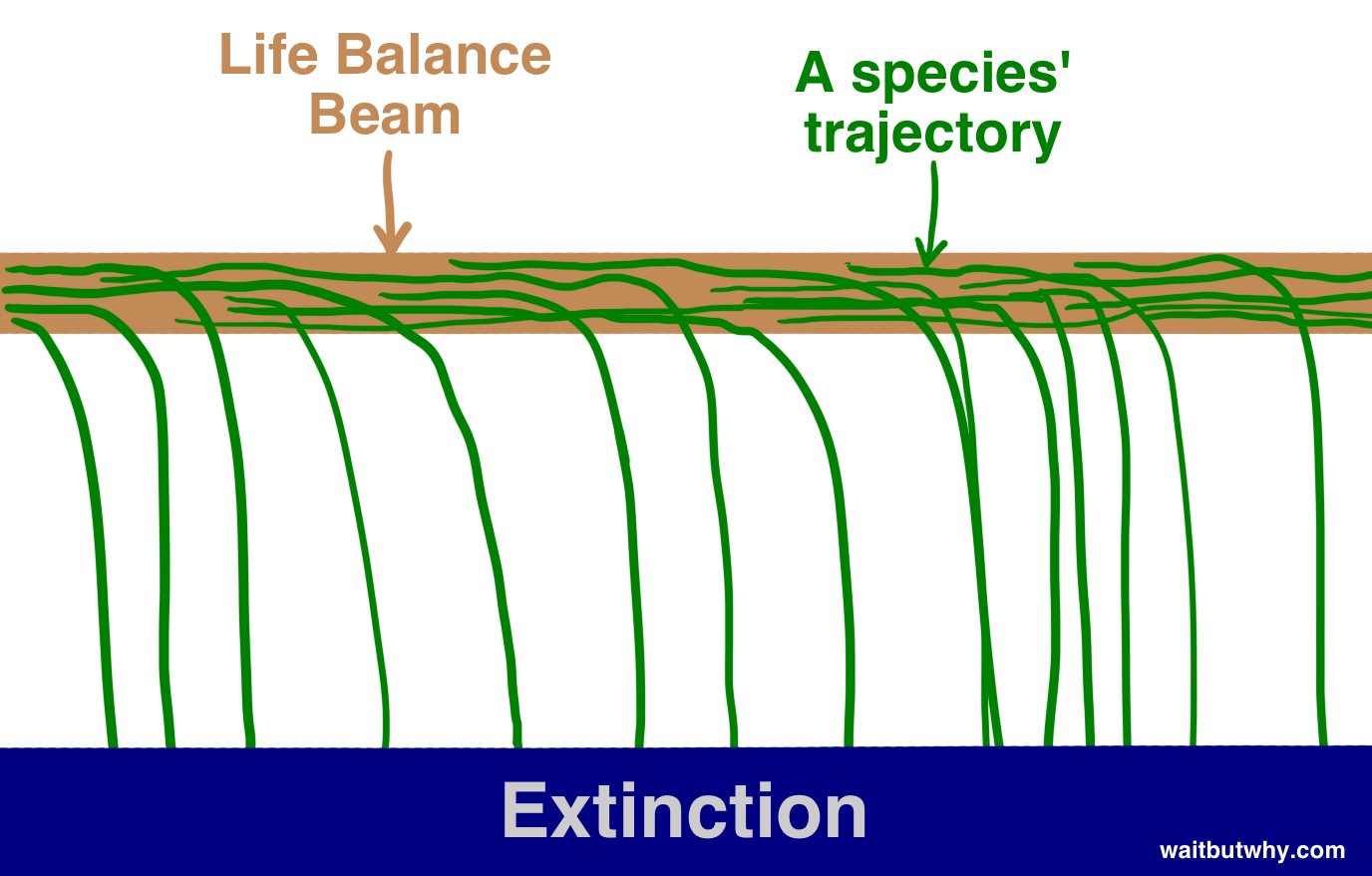

首先,纵观历史,我们可以看到生命是这样运作的:物种出现,存在一段时间,然后不可避免地,它们从存在的平衡木上跌落,坠入灭绝的深渊——

“所有物种终将灭绝”这一规律在历史上几乎与“所有人终有一死”一样可靠。迄今为止,99.9%的物种已从平衡木上跌落,显而易见的是,如果一个物种在平衡木上摇摇欲坠,那么其他物种、自然界的狂风,或是突然震动平衡木的小行星将其击落,只是时间问题。博斯特罗姆将灭绝称为一种吸引态——所有物种都在此边缘摇摇欲坠,且一旦坠入,便再无归途。

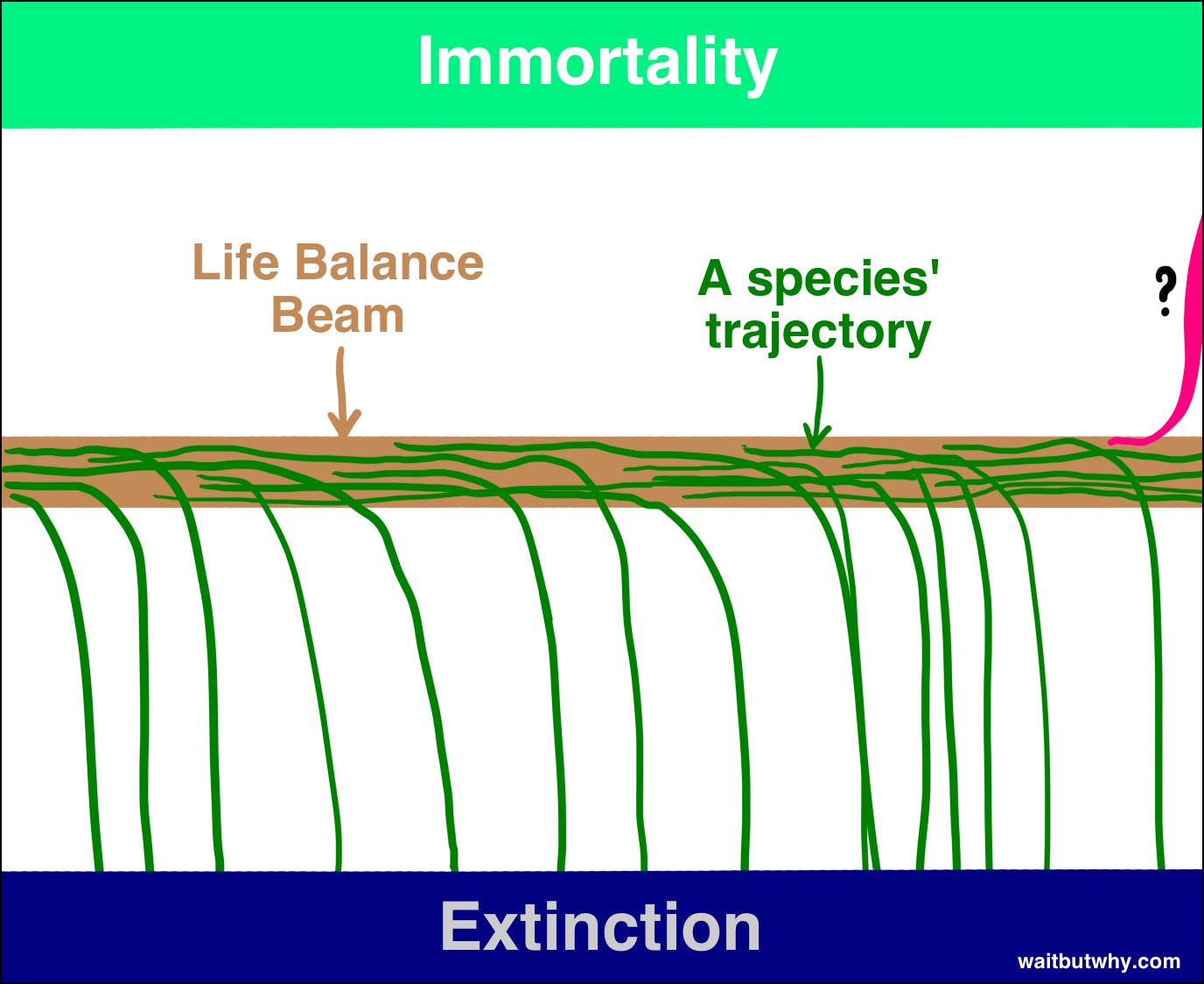

尽管我遇到的大多数科学家都承认,超级人工智能(ASI)有能力导致人类灭绝,但许多人也认为,如果善加利用,ASI 的能力可以将个体人类乃至整个物种推向第二个吸引态——物种永生。博斯特罗姆认为,物种永生与物种灭绝一样,都是一个吸引态,也就是说,如果我们能够达到这个状态,我们将永远免受灭绝的威胁——我们将战胜死亡,战胜偶然性。因此,尽管迄今为止所有物种都从平衡木上跌落,最终走向了灭绝,但博斯特罗姆相信,平衡木有两面,只是地球上还没有任何事物足够聪明,能够找到如何从另一面跌落的方法。

如果博斯特罗姆和其他人的观点是正确的,而且从我阅读的所有资料来看,他们似乎确实可能是对的,那么我们需要接受两个相当令人震惊的事实:

ASI 的出现将首次为一个物种打开通往平衡木上永生一侧的可能性。

人工超级智能(ASI)的出现将带来难以想象的巨大冲击,很可能使人类偏离正轨,走向某一极端。

很可能当进化触及警戒线时,它将永久终结人类与光束的关系,并创造一个全新的世界,无论是否有人类存在。

目前人类唯一应该问的问题似乎是:我们何时会触发警戒线,以及当那一刻来临时,我们会落在哪一边?

世界上没有人知道这个问题的任何一部分的答案,但许多最聪明的人已经为此思考了几十年。我们将在本文的剩余部分探讨他们的研究成果。

让我们从问题的第一部分开始:我们何时会触发警戒线?

即,第一台机器达到超级智能需要多长时间?

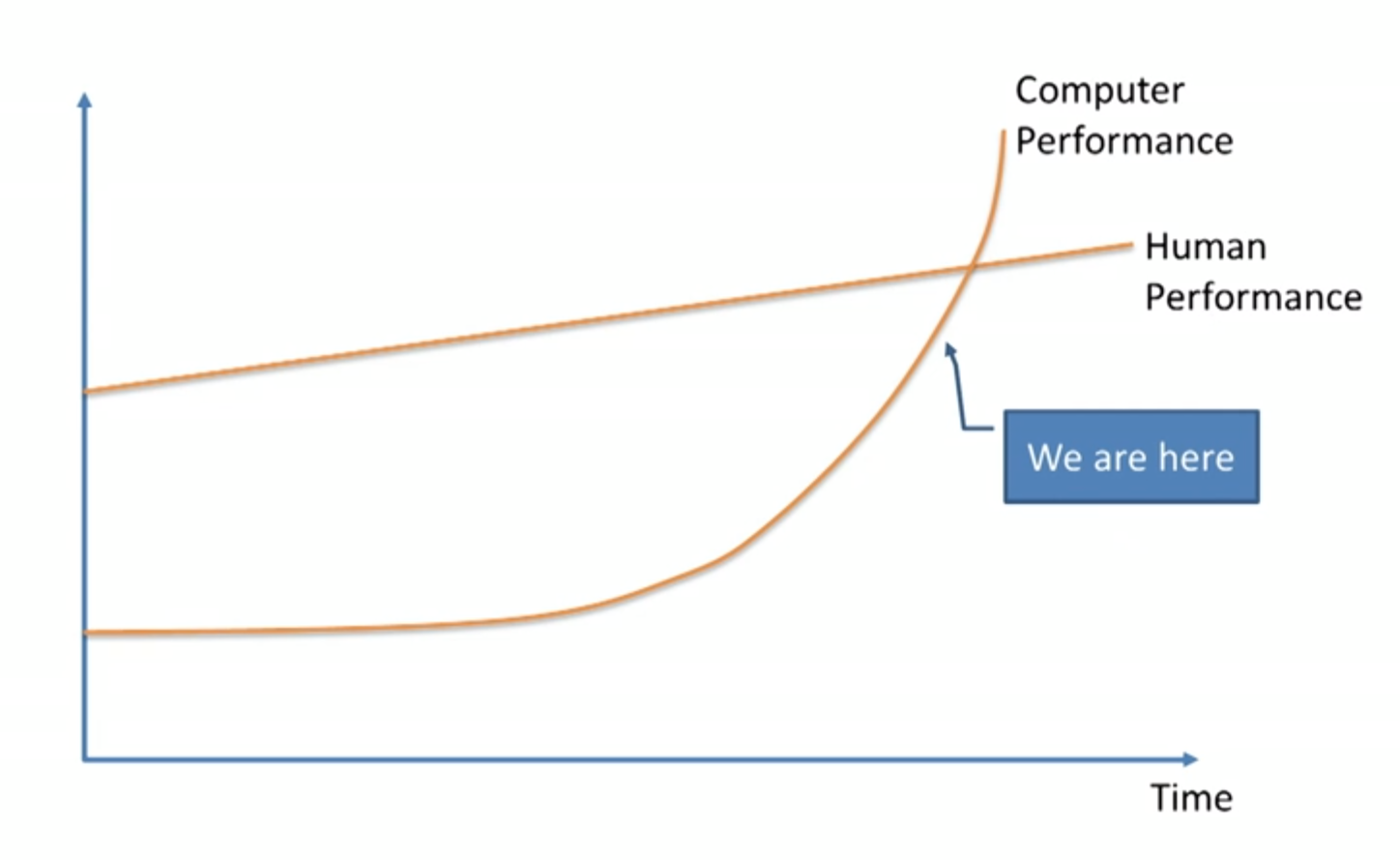

毫不意外,观点千差万别,这在科学家和思想家中引发了激烈的辩论。许多人,如教授弗诺·文奇、科学家本·戈策尔、Sun Microsystems 联合创始人比尔·乔伊,以及最为著名的发明家兼未来学家雷·库兹韦尔,都赞同机器学习专家杰里米·霍华德在 TED 演讲中展示这张图表时的观点:

这些人坚信这一变革即将到来——指数级增长正在发挥作用,尽管机器学习目前只是缓慢地渗透进我们的生活,但在未来几十年内,它将迅速超越我们。

其他人,如微软联合创始人保罗·艾伦、研究心理学家加里·马库斯、纽约大学计算机科学家欧内斯特·戴维斯以及科技企业家米奇·卡普尔,认为像库兹韦尔这样的思想家大大低估了挑战的艰巨性,并相信我们实际上离触发点还远得很。

库兹韦尔阵营会反驳说,唯一被低估的是对指数增长的忽视,他们会将怀疑者比作那些在 1985 年看着互联网缓慢萌芽并认为它不可能在不久的将来产生任何重大影响的人。

怀疑者可能会反驳说,推动智能进步所需的努力也会随着每一步的推进而呈指数级增长,这将抵消技术进步的典型指数特性。如此等等。

第三阵营,包括尼克·博斯特罗姆在内,认为双方都没有理由对时间线感到确定,并承认:A)这完全有可能在不久的将来发生;B)对此并无保证,也可能需要更长的时间。

还有一些人,如哲学家休伯特·德雷福斯,认为这三类人都过于天真,因为他们相信存在这样一条警戒线,而实际上更有可能的是,超级人工智能(ASI)根本不会被实现。

那么,当你把这些观点综合起来时,会得到什么呢?

2013 年,Vincent C. Müller 和 Nick Bostrom 进行了一项调查,他们在系列会议上向数百位人工智能专家提出了以下问题:“为了本题目的考虑,假设人类的科学活动在没有重大负面干扰的情况下持续进行。您认为在(10% / 50% / 90%)的概率下,这样的高级机器智能(HLMI4)将在哪一年出现?”他们被要求给出一个乐观的年份(即他们认为有 10%的可能性实现通用人工智能(AGI)的年份),一个现实的猜测(即他们认为有 50%的可能性实现 AGI 的年份——也就是说,他们认为在那一年之后实现 AGI 的可能性更大),以及一个保守的猜测(即他们能以 90%的确定性断言我们将在那一年之前实现 AGI 的最早年份)。将这些数据汇总为一个数据集,结果如下:

- 中位乐观年份(10%可能性):2022

- 现实年份中位数(50%可能性):2040

- 中位悲观年份(90%可能性):2075

因此,中位数参与者认为 25 年后我们拥有 AGI 的可能性更大。2075 年的 90%中位数答案意味着,如果你现在是个青少年,中位数受访者以及超过一半的 AI 专家群体几乎可以肯定 AGI 将在你有生之年实现。

最近,作者詹姆斯·巴拉特在本·戈策尔年度 AGI 会议上进行的一项独立研究摒弃了百分比,直接询问参与者认为 AGI 何时能够实现——2030 年、2050 年、2100 年、2100 年以后,还是永远不会。结果如下:

- 2030 年后:42%的受访者

- 2050 年后:25%

- 2100 年后:20%

- 2100 年后:10%

- 从不:2%

与 Müller 和 Bostrom 的研究结果颇为相似。在 Barrat 的调查中,超过三分之二的参与者认为到 2050 年 AGI(人工通用智能)将会出现,而略少于一半的人预测 AGI 将在未来 15 年内实现。同样引人注目的是,仅有 2%的受访者认为 AGI 不会成为我们未来的一部分。

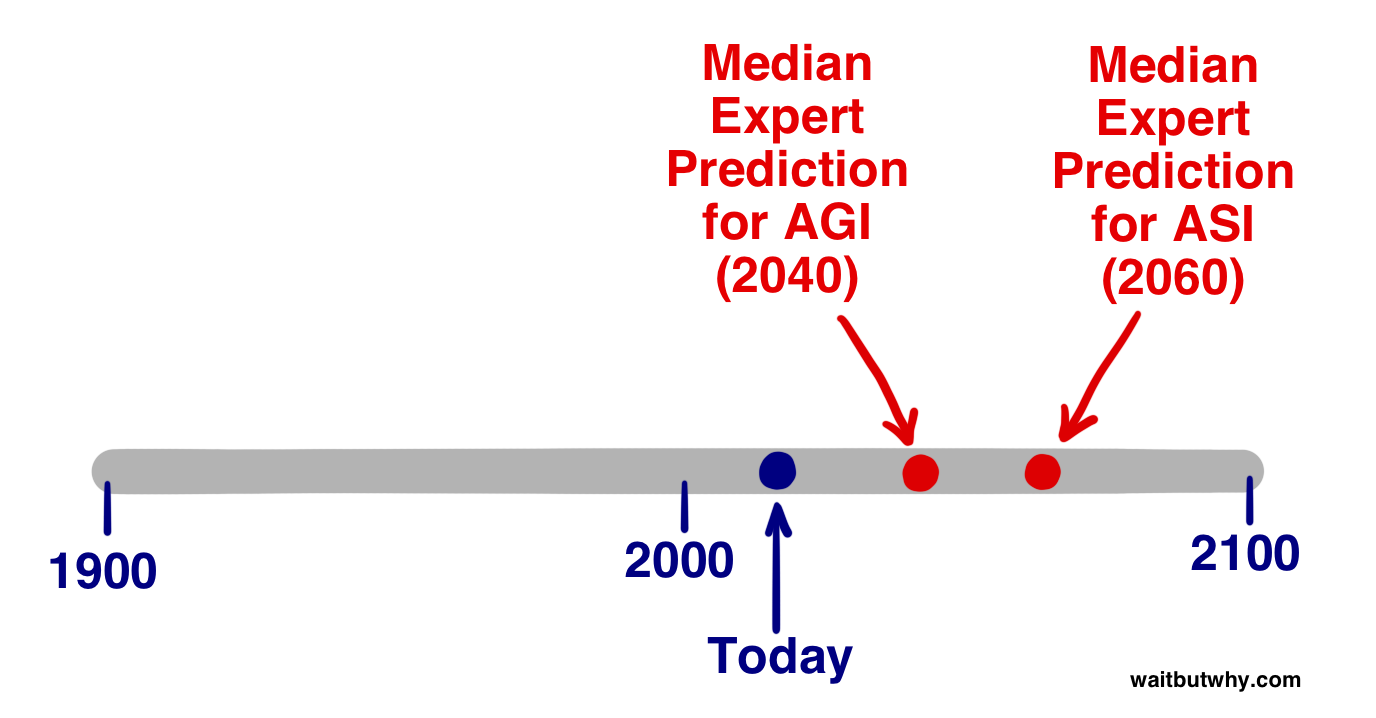

但 AGI 并非触发点,ASI 才是。那么专家们认为我们何时会达到 ASI 呢?

米勒和博斯特罗姆还询问了专家们,他们认为在实现 AGI 后的两年内(即几乎立即发生智能爆炸)以及 30 年内实现 ASI 的可能性有多大。结果如下:

中位数答案认为,从 AGI 到 ASI 的快速(2 年)过渡仅有 10%的可能性,而 30 年或更短的较长过渡则有 75%的可能性。

从这些数据中,我们无法得知中位数参与者认为这一过渡期有多长,且其可能性为 50%。但为了大致估算,基于上述两个答案,我们假设他们会说 20 年。因此,中位数观点——即处于 AI 专家世界正中心的看法——认为,我们触发 ASI(人工超级智能)的最现实时间猜测是[对 AGI(人工通用智能)的 2040 年预测 + 我们估计的从 AGI 到 ASI 的 20 年过渡期] = 2060 年。

当然,上述所有统计数据都是推测性的,它们仅代表人工智能专家群体的主流观点,但这告诉我们,了解这一主题最深的人群中,有很大一部分会认同 2060 年是一个对于可能改变世界的超级人工智能(ASI)到来的非常合理的预估。距离现在仅有 45 年。

好的,现在来谈谈上面问题的第二部分:当我们触发绊线时,会跌落到梁的哪一侧?

超级智能将带来巨大的力量——对我们而言,关键问题是:

谁或什么将掌控这种力量,他们的动机又是什么?

这个问题的答案将决定 ASI 是一项难以置信的伟大发展,还是一项深不可测的可怕发展,或者介于两者之间。

当然,专家社区再次对此问题的答案展开了广泛而激烈的讨论。穆勒和博斯特罗姆的调查要求参与者为 AGI 可能对人类产生的影响分配概率,结果发现,平均而言,有 52%的概率认为结果会是好的或极好的,31%的概率认为结果会是坏的或极坏的。而对于相对中性的结果,平均概率仅为 17%。换句话说,最了解这一领域的人们相当确信,这将是件大事。值得注意的是,这些数字指的是 AGI 的出现——如果问题涉及 ASI,我猜想中性的百分比会更低。

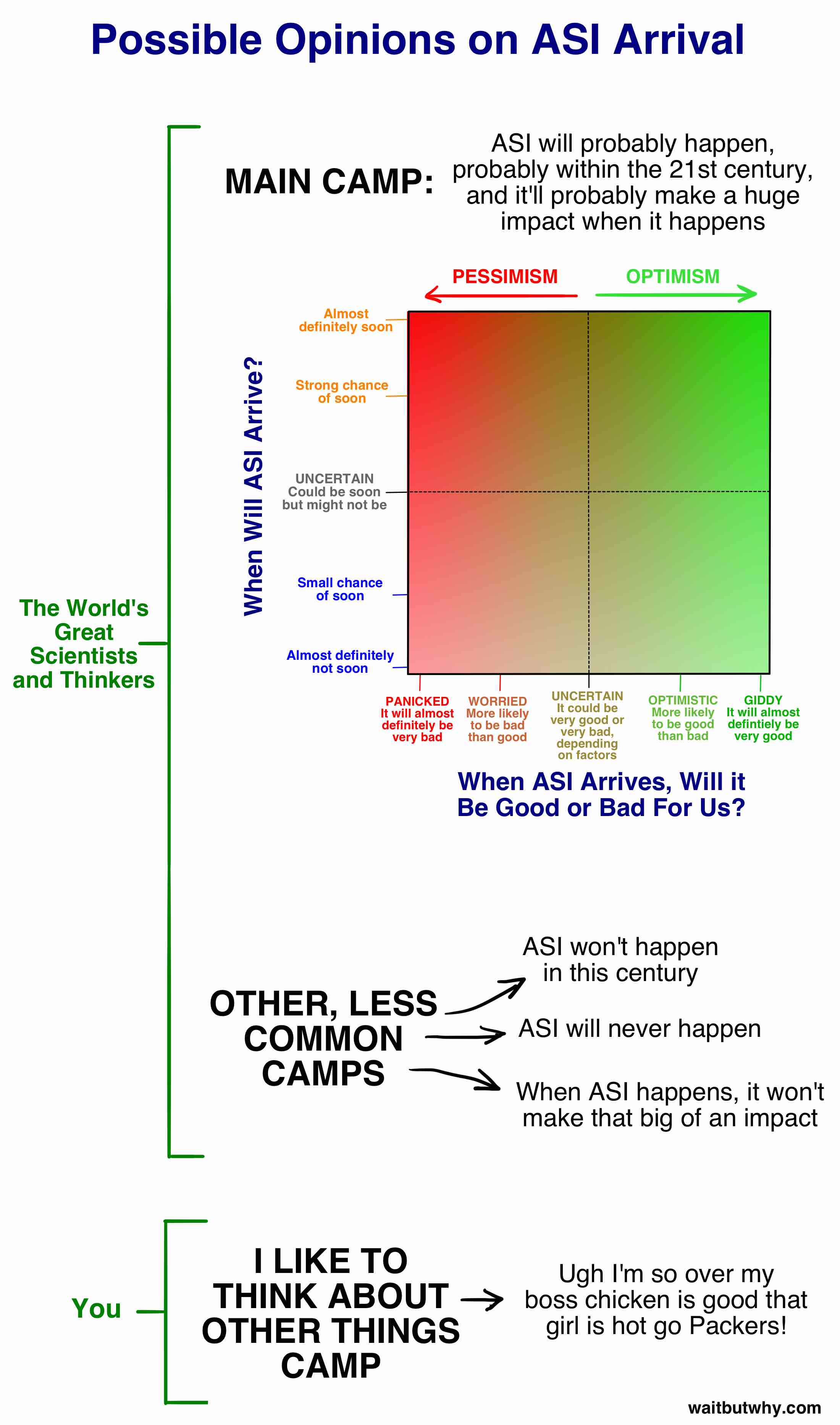

在我们深入探讨这个问题中“好与坏结果”的部分之前,让我们将“何时会发生?”和“结果是好是坏?”这两个部分结合起来,绘制一张图表,涵盖大多数相关专家的观点:

我们稍后会详细讨论主阵营,但首先——你的情况如何?其实我知道你的情况,因为在我开始研究这个话题之前,我也是这样。大多数人没有真正思考这个话题的一些原因:

- 正如第一部分所述,电影通过呈现不切实际的人工智能场景,使人们普遍认为人工智能并不值得认真对待,从而混淆了视听。詹姆斯·巴拉特将这种情况比作如果疾病控制中心对未来吸血鬼发出严重警告时我们的反应。

- 人类往往在亲眼见到证据之前,很难相信某件事是真实的。我确信 1988 年的计算机科学家们经常讨论互联网将会有多么重要,但人们可能直到互联网真正改变了他们的生活,才真正意识到这一点。这部分是因为在 1988 年,计算机还无法实现那样的功能,所以人们看着自己的电脑会想:“真的吗?这将会是改变生活的东西?”他们的想象力局限于个人经验所告诉他们的计算机是什么,这使得他们很难生动地想象计算机未来会变成什么样子。现在,同样的事情正在人工智能领域发生。我们听说它将会非常重要,但由于它尚未发生,并且由于我们当前世界中相对无力的 AI 体验,我们很难真正相信这将极大地改变我们的生活。而这些偏见正是专家们在试图通过日常集体自我关注的喧嚣中引起我们注意时所面临的挑战。

- 即便我们真的相信这一点——今天你有多少次想到,在永恒的大部分时间里,你将不复存在?并不多,对吧?尽管这比你今天所做的任何事情都更为深刻?这是因为我们的大脑通常专注于日常生活中的琐事,无论我们身处多么疯狂的长远情境中。这就是我们大脑的运作方式。

这两篇文章的目标之一是将你从“我喜欢思考其他事情”的阵营中拉出来,带入专家阵营之一,即使你只是站在上方正方形中两条虚线的交叉点上,完全不确定。