Claude 的扩展思考能力

有些事情我们几乎瞬间就能完成,比如“今天星期几?”。而另一些则需要更多的脑力,比如解一个隐晦的填字游戏或调试一段复杂的代码。我们可以根据手头的任务选择投入或多或少的认知努力。

现在,Claude 也拥有了同样的灵活性。借助新的 Claude 3.7 Sonnet,用户可以开启或关闭“扩展思考模式 (extended thinking mode)”,指示模型更深入地思考更棘手的问题1。开发者甚至可以设置“思考预算 (thinking budget)”,来精确控制 Claude 在一个问题上花费的时间。

扩展思考模式 (extended thinking mode) 并不是切换到采用不同策略的另一个模型的选项。相反,它允许 同一个 模型给自己更多的时间,并投入更多的精力,来得出答案。

Claude 全新的扩展思考能力 (extended thinking capability) 为其智能带来了令人印象深刻的提升。但它也为那些对 AI 模型如何工作、如何评估以及如何提高其安全性感兴趣的人提出了许多重要问题。在这篇文章中,我们将分享我们获得的一些见解。

可见的思考过程

除了赋予 Claude 更长时间思考从而回答更棘手问题的能力之外,我们还决定以原始形式公开其思考过程。这有几个好处:

- 信任 (Trust)。 能够观察 Claude 的思考方式,可以更容易地理解和检查其答案——并且可能帮助用户获得更好的输出。

- 对齐 (Alignment)。 在我们之前的对齐科学研究 (Alignment Science research) 中,我们曾利用模型内心想法和外在言语之间的矛盾来识别它何时可能参与诸如欺骗等令人担忧的行为。

- 趣味性 (Interest)。 观看 Claude 思考通常非常有趣。我们一些具有数学和物理背景的研究人员注意到,Claude 的思考过程与他们自己推理解决难题的方式惊人地相似:探索许多不同的角度和推理分支,并反复检查答案。

但可见的思考过程也有一些缺点。首先,用户可能会注意到,公开的思考过程比 Claude 的默认输出更疏远且不那么个性化。这是因为我们没有对模型的思考过程进行标准的角色 (character) 训练。我们希望给予 Claude 最大的自由,思考得出答案所需的任何想法——就像人类思考一样,Claude 有时会发现自己思考出一些不正确、误导性或半生不熟的想法。许多用户会觉得这很有用;另一些人可能会觉得它(以及思考过程中较少角色化的内容)令人沮丧。

另一个问题是所谓的“忠实性 (faithfulness)”——我们不确定思考过程中显示的内容是否真正代表了模型头脑中发生的事情(例如,思考过程中显示的英语单词可能根本无法描述模型为何表现出特定行为)。忠实性 (faithfulness) 问题——以及如何确保它——是我们积极研究的领域之一。到目前为止,我们的结果表明,模型通常会根据它们在思考过程中 没有 明确讨论的因素做出决定。这意味着我们不能依赖于监控当前模型的思考来为其安全性提供有力的论据2。

第三,它带来了一些安全和安保方面的担忧。恶意行为者可能能够利用可见的思考过程来构建更好的策略来越狱 (jailbreak) Claude。更具推测性的是,如果模型在训练过程中了解到它们的内部想法将被公开展示,它们可能会被激励以不同、更不可预测的方式思考——或者故意隐藏某些想法。

对于未来能力更强的 Claude 版本——如果不对齐会带来更大风险的版本——这些后者的担忧将尤其突出。我们将权衡在未来版本中公开思考过程的利弊3。与此同时,Claude 3.7 Sonnet 中可见的思考过程应被视为研究预览版。

Claude 思考能力的新测试

Claude 作为智能体 (agent)

Claude 3.7 Sonnet 受益于我们可以称之为“行动扩展 (action scaling)”的能力——一种改进的能力,使其能够迭代地调用函数、响应环境变化并持续执行直到开放式任务完成。此类任务的一个示例是使用计算机:Claude 可以发出虚拟鼠标点击和键盘按键,代表用户解决任务。与其前代产品相比,Claude 3.7 Sonnet 可以为计算机使用任务分配更多轮次——以及更多时间和计算能力——并且其结果通常更好。

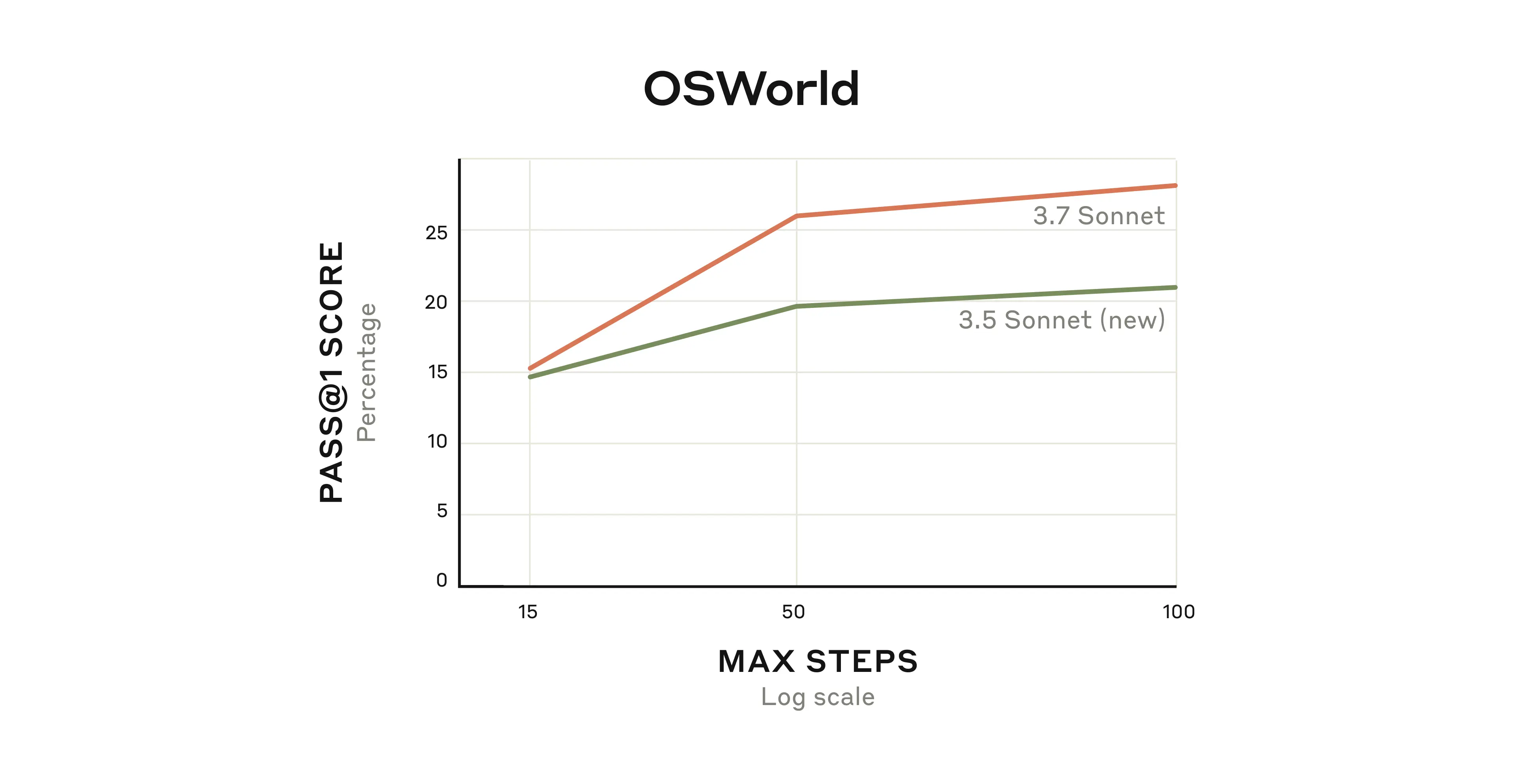

我们可以从 Claude 3.7 Sonnet 在 OSWorld 上的改进中看到这一点,OSWorld 是一项评估多模态 AI 智能体 (agent) 能力的评测。Claude 3.7 Sonnet 的起步稍好一些,但随着模型继续与虚拟计算机交互,性能差异会随着时间推移而扩大。

Claude 3.7 Sonnet 与其前代模型在 OSWorld 评估中的性能对比,该评估测试了多模态计算机使用技能。“Pass @ 1”:模型只有一次尝试解决特定问题的机会,才能算作通过。

总而言之,Claude 的扩展思考能力 (extended thinking) 和智能体 (agent) 训练帮助它在许多标准评估(如 OSWorld)中表现更好。但它们也为其他一些可能更出乎意料的任务带来了重大提升。

玩 Pokémon——特别是 Game Boy 经典游戏《精灵宝可梦 红 (Pokémon Red)》——就是这样一项任务。我们为 Claude 配备了基本内存、屏幕像素输入和函数调用,以按下按钮并在屏幕上导航,使其能够在超出其通常上下文限制的情况下持续玩 Pokémon,并通过数万次交互维持游戏进行。

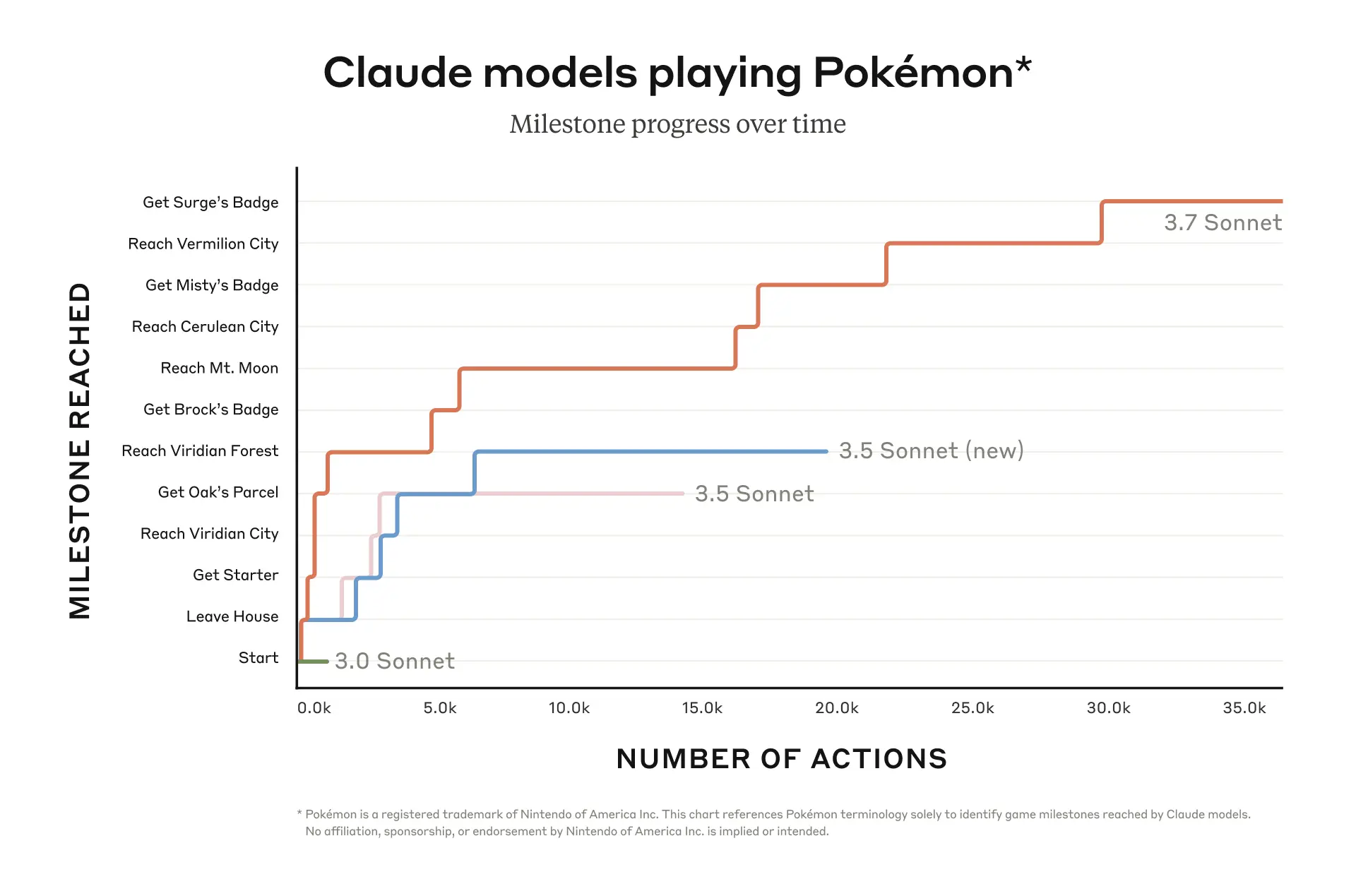

在下面的图表中,我们绘制了 Claude 3.7 Sonnet 以及之前版本的 Claude Sonnet 的 Pokémon 游戏进度,之前的版本没有扩展思考 (extended thinking) 的选项。正如您所看到的,之前的版本在游戏早期就卡住了,其中 Claude 3.0 Sonnet 甚至未能离开故事开始的真新镇房子。

但 Claude 3.7 Sonnet 改进的智能体 (agentic) 能力帮助它取得了更大的进展,成功地与三位 Pokémon 道馆馆主(游戏 Boss)战斗并赢得了他们的徽章。Claude 3.7 Sonnet 在尝试多种策略和质疑先前假设方面非常有效,这使其能够在进步过程中提高自身能力。

Claude 3.7 Sonnet 表明,在玩《精灵宝可梦 红 (Pokémon Red)》方面,它是迄今为止所有 Sonnet 模型中表现最好的。x 轴是 Claude 在玩游戏时完成的交互次数;y 轴是游戏中重要的里程碑,包括收集特定物品、导航到特定区域以及击败特定游戏 Boss。

Pokémon 是一种有趣的方式来欣赏 Claude 3.7 Sonnet 的能力,但我们预计这些能力将在游戏之外的现实世界中产生实际影响。模型保持专注并完成开放式目标的能力将帮助开发者构建各种最先进的 AI 智能体 (agent)。

串行和并行测试时计算扩展 (Serial and parallel test-time compute scaling)

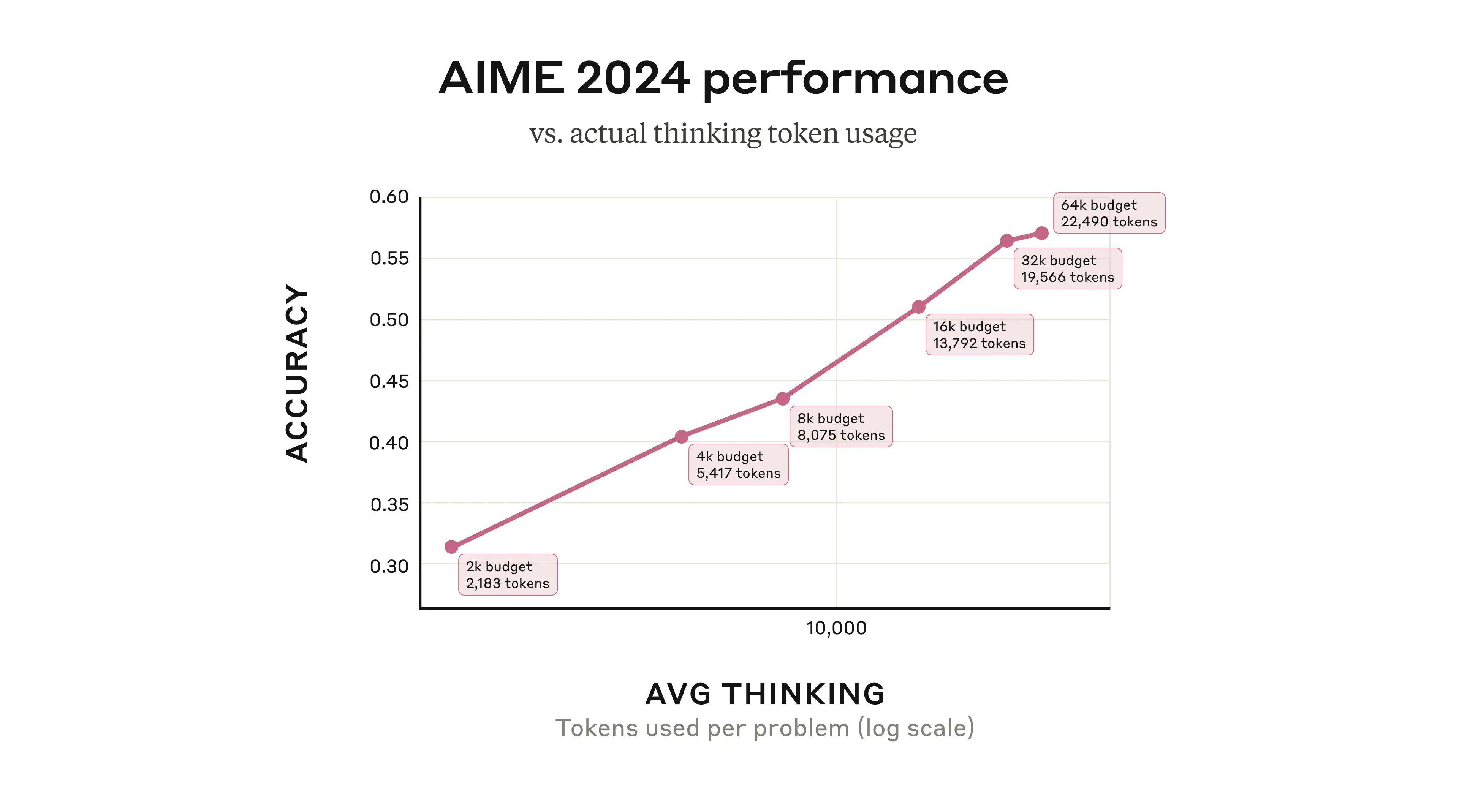

当 Claude 3.7 Sonnet 使用其扩展思考能力 (extended thinking capability) 时,它可以被描述为受益于“串行测试时计算 (serial test-time compute)”。也就是说,它在生成最终输出之前使用了多个连续的推理步骤,并随着过程进行添加了更多计算资源。总的来说,这以可预测的方式提高了其性能:例如,它在数学问题上的准确性随着允许采样的“思考 tokens (thinking tokens)”数量呈对数增长。

Claude 3.7 Sonnet 在 2024 年美国邀请数学竞赛 (American Invitational Mathematics Examination 2024) 中的问题上的表现,根据每个问题允许的思考 tokens (thinking tokens) 数量而定。请注意,即使我们允许 Claude 使用整个思考预算 (thinking budget),它通常也会提前停止。我们在图中包含了用于总结最终答案的采样 tokens。

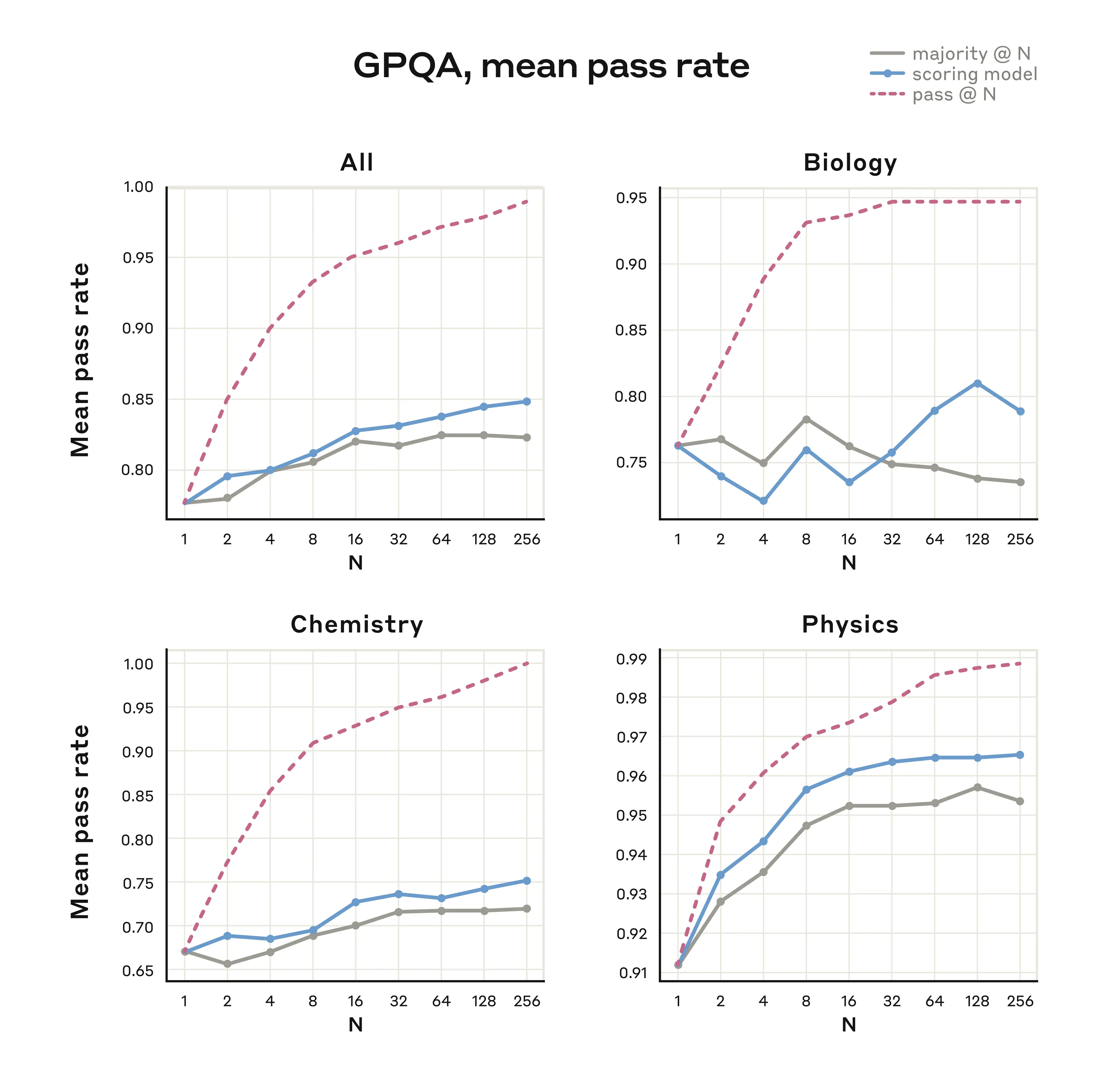

我们的研究人员还一直在试验使用 并行 测试时计算 (parallel test-time compute) 来提高模型的性能。他们通过采样多个独立的思考过程并选择最佳的一个来做到这一点,而无需事先知道正确答案。一种方法是使用多数或共识投票;选择最常作为“最佳”答案出现的答案。另一种方法是使用另一个语言模型(例如 Claude 的第二个副本),要求其检查其工作或学习到的评分函数,并选择它认为最佳的答案。在 几 个 其他 AI 模型 的评估结果 中也报告了此类策略(以及类似的工作)。

我们在 GPQA 评估 中使用并行测试时计算扩展 (parallel test-time compute scaling) 取得了显著的改进,GPQA 评估是一组常用的生物学、化学和物理学方面的挑战性问题。使用相当于 256 个独立样本的计算量、一个学习到的评分模型和一个最大 64k-tokens (tokens) 的思考预算 (thinking budget),Claude 3.7 Sonnet 实现了 84.8% 的 GPQA 分数(包括 96.5% 的物理学子分数),并受益于超出多数票限制的持续扩展。我们在下面报告了我们的评分模型方法和多数票方法的结果。

使用并行测试时计算扩展 (parallel test-time compute scaling) 来提高 Claude 3.7 Sonnet 在 GPQA 评估中性能的实验结果。不同的线条代表不同的性能评分方法。“Majority @ N”:其中从同一提示的模型生成多个输出,并将多数票作为最终答案;“scoring model (评分模型)”:用于评估被评估模型性能的单独模型;“pass @ N”:其中模型在给定次数的尝试中任何一次成功就“通过”测试。

诸如此类的方法使我们能够提高 Claude 答案的质量,通常无需等待其完成思考。Claude 可以同时进行多个不同的扩展思考过程 (extended thought processes),使其能够考虑更多解决问题的方法,并最终更频繁地得到正确答案。并行测试时计算扩展 (parallel test-time compute scaling) 在我们新部署的模型中尚不可用,但我们正在继续研究未来的这些方法。

Claude 3.7 Sonnet 的安全机制

AI 安全级别 (AI Safety Level)。 Anthropic 的 负责任的扩展政策 (Responsible Scaling Policy) 承诺,除非我们实施了适当的安全和安保措施,否则我们不会训练或部署模型。我们的前沿红队 (Frontier Red Team) 和对齐压力测试团队 (Alignment Stress Testing team) 对 Claude 3.7 Sonnet 进行了广泛的测试,以确定它是否需要与我们之前的模型——称为 AI 安全级别 (AI Safety Level, ASL) 2 标准——相同级别的部署和安全保障,还是更强的措施。

我们对 Claude 3.7 Sonnet 的全面评估证实,我们当前的 ASL-2 安全标准仍然适用。与此同时,该模型在所有领域都表现出更高的成熟度和更高的能力。在检查与生产化学、生物、放射性和核 (Chemical, Biological, Radiological, and Nuclear, CBRN) 武器相关的任务的受控研究中,我们观察到与非辅助参与者相比,模型辅助参与者的某些性能“提升”。也就是说,参与者比仅仅使用在线可用的信息更能接近成功。然而,所有执行这些任务的尝试都包含关键性失败,完全阻碍了成功。

对模型进行的专家红队测试 (expert red-teaming) 产生了褒贬不一的反馈。虽然一些专家注意到模型在 CBRN 过程某些领域的知识有所提高,但他们也发现关键性失败的频率太高,无法成功完成端到端任务。我们正在通过加速开发和部署有针对性的分类器和监控系统来积极加强我们的 ASL-2 措施。

此外,我们未来模型的能力可能需要我们进入下一阶段:ASL-3 保障措施。我们最近在宪法分类器 (Constitutional Classifiers) 方面为防止越狱 (jailbreaks) 所做的工作,以及其他努力,使我们能够很好地在不久的将来实施 ASL-3 标准的要求。

可见的思考过程 (Visible thought process)。 即使在 ASL-2 级别,Claude 3.7 Sonnet 的可见扩展思考功能 (visible extended thinking feature) 也是一项新功能,因此需要新的和适当的保障措施。在极少数情况下,Claude 的思考过程可能包含潜在有害的内容(主题包括儿童安全、网络攻击和危险武器)。在这种情况下,我们将加密思考过程:这不会阻止 Claude 将内容包含在其思考过程中(这对于最终生成完全良性的响应仍然很重要),但思考过程的相关部分对用户不可见。相反,他们将看到消息“the rest of the thought process is not available for this response (此响应的其余思考过程不可用)”。我们的目标是使这种加密很少发生,并且仅在潜在危害较高的情况下发生。

计算机使用 (Computer use)。 最后,我们加强了 Claude 计算机使用能力的安全措施(我们在上面讨论过:它允许 Claude 查看用户的计算机屏幕并代表他们执行操作)。我们在防御“提示注入 (prompt injection)”攻击方面取得了重大进展,在这种攻击中,恶意第三方将秘密消息隐藏在 Claude 在使用计算机时可能看到的位置,从而可能诱骗它采取用户不希望采取的操作。通过新的抵抗提示注入 (prompt injection) 的训练、包含忽略这些攻击指令的新系统提示以及在模型遇到潜在的提示注入 (prompt injection) 时触发的分类器,我们现在可以防止 88% 的此类攻击4,高于没有缓解措施时的 74%。

以上只是我们对 Claude 3.7 Sonnet 进行的大量安全工作的一些简要总结。有关更多信息、分析结果以及安全措施实际应用的几个示例,请参阅我们的完整系统卡 (System Card)。

使用 Claude

您现在可以在 Claude.ai 或 我们的 API 上使用 Claude 3.7 Sonnet。正如 Claude 现在可以让你知道它的想法一样,我们希望你也让我们知道你的想法。请将您对新模型的反馈发送至 feedback@anthropic.com。

脚注

具体而言,这适用于 Claude Pro、Team、Enterprise 和 API 用户。

我们的忠实性 (faithfulness) 研究在我们的系统卡 (System Card) 中有更详细的描述。我们还希望,通过未来在机制可解释性 (mechanistic interpretability) 方面的进步,可以实现对模型行为原因的全面理解,达到其神经网络中激活的水平。

在完全公开思考过程和完全隐藏思考过程之间可能存在一种中间方式。例如,训练模型在被问及内部思考过程时始终保持真实可能是更可取的,但默认情况下不公开这些想法(并且可能能够拒绝某些请求)。

这伴随着 0.5% 的误报率(即,即使不存在提示注入 (prompt injection) 攻击,安全措施也会触发)。我们正在努力降低此比率,同时开发我们的安全机制。